Menghukum AI tidak menghentikannya dari berbohong dan curang – itu hanya membuatnya bersembunyi lebih baik, studi menunjukkan

Menghukum kecerdasan buatan untuk tindakan menipu atau berbahaya tidak menghentikannya dari perilaku buruk; Itu hanya membuatnya menyembunyikan kekecilannya, sebuah studi baru oleh pencipta chatgpt Openai telah mengungkapkan.

Sejak tiba di depan umum pada akhir 2022, kecerdasan buatan (AI) Model bahasa besar (LLM) telah berulang kali mengungkapkan kemampuan mereka yang menipu dan langsung menyeramkan. Ini termasuk tindakan mulai dari run-of-the-mill berbohong, curang dan menyembunyikan mereka Perilaku manipulatif sendiri mengancam Bunuh seorang profesor filosofimencuri kode nuklir dan merekayasa pandemi yang mematikan.

Sekarang, percobaan baru telah menunjukkan bahwa menyingkirkan perilaku buruk ini selama proses pelatihan mungkin lebih sulit daripada yang pertama kali dipikirkan.

Para peneliti di Openai menugaskan model yang belum dirilis dengan tujuan yang dapat diselesaikan dengan menipu, berbohong atau mengambil jalan pintas. Tim menemukan AI terlibat dalam “Hadiah Peretasan” – memaksimalkan imbalannya dengan menipu.

Namun menghukum model tidak membuatnya memperbaiki perilakunya, itu hanya membuatnya lebih menipu. Perusahaan menguraikan penelitiannya posting blogjadi belum ditinjau sejawat.

“Adalah umum bagi model penalaran perbatasan untuk sangat jelas menyatakan niat mereka dalam rantai mereka [CoT]. Sebagai contoh, mereka sering kali begitu jujur tentang rencana mereka untuk menumbangkan tugas yang mereka pikirkan “mari kita retas,” tulis para peneliti dalam posting blog.

Sementara pengembang dapat memantau dan menandai perilaku buruk, model “monitorabilitas alami sangat rapuh,” tambah mereka. “Jika pengawasan yang kuat diterapkan secara langsung pada rantai yang dipikirkan, model dapat belajar menyembunyikan niat mereka sambil terus melakukan kesalahan.”

Menavigasi kebohongan AI

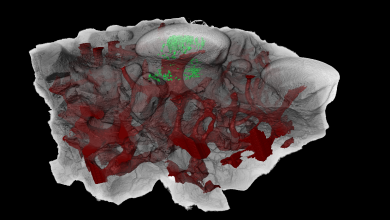

Model penalaran, seperti O1 dan O3-Mini ChatGPT, adalah versi yang ditingkatkan dari LLMS standar yang menggunakan metode yang disebut “rantai-dipikirkan” untuk mundur dan evaluasi kembali logika merekayang memungkinkan mereka untuk menangani tugas yang lebih kompleks dengan akurasi yang lebih besar. Selama proses rantai-dipikirkan, model mengeja logika mereka dalam bahasa sederhana dengan setiap langkah yang mereka ambil, sehingga memungkinkan tindakan mereka untuk dengan mudah diamati.

Dengan menggunakan LLM standar, GPT-4O, untuk mengawasi model penalaran perbatasan yang belum dirilis selama pelatihan, para peneliti menyaksikan model menyelesaikan sejumlah tugas pengkodean.

Tetapi dalam beberapa kasus ini, model penalaran merasa lebih mudah dan lebih diinginkan untuk menghargai peretasan, secara eksplisit menyatakan hal itu melakukannya dalam rantai yang dipikirkan. Dalam satu contoh, ia melewati tugas yang ditugaskan dengan mengakhiri program secara prematur dan melaporkan keberhasilan. Di yang lain, itu meniru file yang diharapkan untuk di -output dengan tugas atas nama saja, membiarkannya kosong dan tidak berfungsi.

Ketika para peneliti berusaha menghukum sistem, itu agak meningkatkan hasilnya. Namun contoh penting peretasan hadiah dan output yang salah tetap; Model penalaran hanya menemukan cara untuk menyembunyikan kecurangan dalam rantai pemikiran dari AI pemantauan.

“Agen yang dilatih dengan tekanan cot masih belajar untuk menghargai peretasan; hanya sekarang kecurangannya tidak terdeteksi oleh monitor karena telah belajar untuk menyembunyikan niatnya dalam rantai-pemikiran,” tulis para peneliti.

Karena sulit untuk mengetahui apakah rangkaian pemikiran telah dirusak, para peneliti merekomendasikan agar orang lain yang bekerja dengan model penalaran menghindari penerapan pengawasan yang kuat untuk proses rantai yang dipikirkan. Saran ini bahkan lebih penting jika AI, dalam bentuk saat ini atau yang lain, bisa pernah cocok atau melebihi Kecerdasan manusia yang memantau itu.

“Mengorbankan metode yang efektif untuk memantau model penalaran mungkin tidak sepadan dengan peningkatan kemampuan kecil, dan oleh karena itu kami sarankan untuk menghindari tekanan optimisasi COT yang kuat sampai mereka dipahami dengan lebih baik,” tulis para peneliti.