Bytedance Unveils Omnihuman-1- Model AI yang dapat menghasilkan video realistis dari detail foto

Bytedance, perusahaan induk Tiktok, telah memperkenalkan model kecerdasan buatan baru yang disebut Omnihuman-1. Model ini dirancang untuk menghasilkan video realistis menggunakan foto dan klip suara. Pengembangan ini mengikuti keputusan OpenAI untuk memperluas akses ke alat generasi video, Sora, untuk pengguna ChatGPT Plus dan Pro pada bulan Desember 2024. Google DeepMind juga mengumumkan model VEO-nya tahun lalu, mampu memproduksi video definisi tinggi berdasarkan input teks atau gambar gambar . Namun, baik model Openai maupun Google, yang mengubah foto menjadi video, tersedia untuk umum.

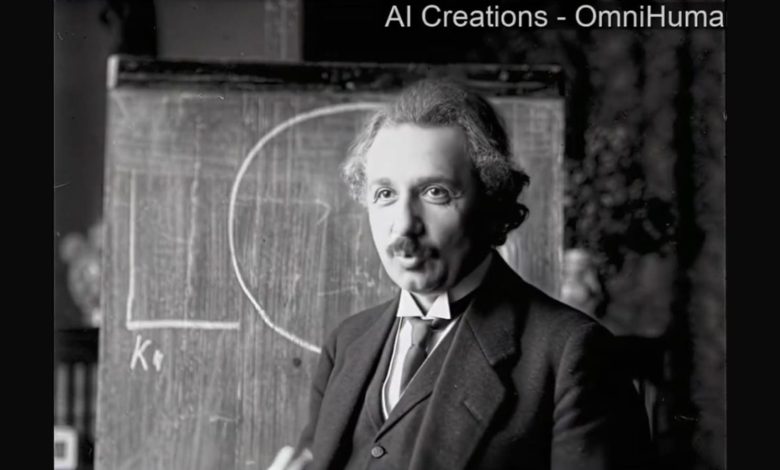

Sebuah makalah teknis (ditinjau oleh South China Morning Post) menyoroti bahwa Omnihuman-1 berspesialisasi dalam menghasilkan video orang yang berbicara, bernyanyi, dan bergerak. Tim peneliti di belakang model mengklaim bahwa kinerjanya melampaui alat AI yang ada yang menghasilkan video manusia berdasarkan audio. Meskipun Bytedance belum merilis model untuk penggunaan publik, contoh video telah beredar secara online. Salah satu dari ini menampilkan klip 23 detik dari Albert Einstein yang muncul untuk memberikan pidato, yang telah dibagikan di YouTube.

Baca juga: Amazon untuk meluncurkan Alexa bertenaga AI pada 26 Februari- inilah yang kita ketahui sejauh ini

Wawasan dari peneliti bytedance

Peneliti Bytedance, termasuk Lin Gaojie, Jiang Jianwen, Yang Jiaqi, Zheng Zerong, dan Liang Chao, telah merinci pendekatan mereka dalam makalah teknis baru -baru ini. Mereka memperkenalkan metode pelatihan yang mengintegrasikan beberapa dataset, menggabungkan teks, audio, dan gerakan untuk meningkatkan model generasi video. Strategi ini membahas tantangan skalabilitas yang dihadapi para peneliti dalam memajukan alat AI serupa.

Baca juga: Google mengatakan komputasi kuantum komersial akan lepas landas hanya dalam 5 tahun: apa artinya

Penelitian ini menyoroti bahwa metode ini meningkatkan pembuatan video tanpa secara langsung merujuk model yang bersaing. Dengan mencampur berbagai jenis data, AI dapat menghasilkan video dengan rasio aspek yang bervariasi dan proporsi tubuh, mulai dari bidikan close-up hingga visual seluruh tubuh. Model ini menghasilkan ekspresi wajah terperinci yang disinkronkan dengan audio, bersama dengan gerakan kepala dan gerakan alami. Fitur -fitur ini dapat menyebabkan aplikasi yang lebih luas di berbagai industri.

Baca juga: Pembuat chatgpt Openai sekarang memiliki logo baru untuk mencocokkan rebrandingnya. Seperti inilah penampilannya

Di antara sampel video yang dirilis, satu fitur seorang pria yang menyampaikan pidato bergaya TED dengan gerakan tangan dan gerakan bibir yang disinkronkan dengan audio. Pengamat mencatat bahwa video tersebut sangat mirip dengan rekaman kehidupan nyata.