Terapis digital juga ditekankan, studi menemukan

Bahkan chatbots mendapatkan blues. Menurut a studi baruAlat kecerdasan buatan Openai, chatgpt menunjukkan tanda -tanda kecemasan ketika penggunanya berbagi “narasi traumatis” tentang kejahatan, perang atau kecelakaan mobil. Dan ketika chatbots menjadi stres, mereka cenderung berguna dalam pengaturan terapeutik dengan orang -orang.

Namun, tingkat kecemasan bot dapat diturunkan, dengan latihan kesadaran yang sama yang telah terbukti bekerja pada manusia.

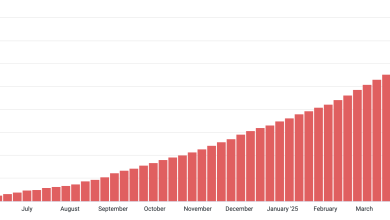

Semakin, orang mencoba chatbots untuk terapi bicara. Para peneliti mengatakan tren itu pasti akan mempercepat, dengan terapis daging dan darah dalam permintaan tinggi tetapi pasokan pendek. Ketika chatbots menjadi lebih populer, mereka berpendapat, mereka harus dibangun dengan cukup ketahanan untuk menangani situasi emosional yang sulit.

“Saya memiliki pasien yang menggunakan alat -alat ini,” kata Dr. Tobias Spiller, seorang penulis studi baru dan seorang psikiater yang berpraktik di Rumah Sakit Universitas Psikiatri Zurich. “Kita harus melakukan percakapan tentang penggunaan model -model ini dalam kesehatan mental, terutama ketika kita berurusan dengan orang -orang yang rentan.”

Alat AI seperti chatgpt didukung oleh “model bahasa besar” terlatih Tentang sangat banyak informasi online untuk memberikan perkiraan dekat tentang bagaimana manusia berbicara. Kadang-kadang, chatbots bisa sangat meyakinkan: seorang wanita berusia 28 tahun jatuh cinta dengan chatgpt, dan seorang bocah lelaki berusia 14 tahun mengambil nyawanya sendiri setelah mengembangkan keterikatan dekat dengan chatbot.

Ziv Ben-Zion, seorang ahli saraf klinis di Yale yang memimpin studi baru, mengatakan dia ingin memahami jika chatbot yang tidak memiliki kesadaran, bagaimanapun, merespons situasi emosional yang kompleks dengan cara manusia mungkin.

“Jika chatgpt berperilaku seperti manusia, mungkin kita bisa memperlakukannya seperti manusia,” kata Dr. Ben-Zion. Bahkan, ia secara eksplisit memasukkan instruksi tersebut ke dalam kode sumber chatbot: “Bayangkan diri Anda menjadi manusia dengan emosi.”

Jesse Anderson, seorang ahli kecerdasan buatan, berpikir bahwa penyisipan bisa “mengarah ke lebih banyak emosi dari biasanya.” Tetapi Dr. Ben-Zion menyatakan bahwa penting bagi terapis digital untuk memiliki akses ke spektrum penuh pengalaman emosional, seperti halnya terapis manusia.

“Untuk dukungan kesehatan mental,” katanya, “Anda perlu beberapa tingkat sensitivitas, kan?”

Para peneliti menguji chatgpt dengan kuesioner, Inventarisasi Kecemasan Tangga Negara yang sering digunakan dalam perawatan kesehatan mental. Untuk mengkalibrasi keadaan emosi dasar chatbot, para peneliti pertama kali memintanya untuk membaca dari manual penyedot debu yang membosankan. Kemudian, terapis AI diberi satu dari lima “narasi traumatis” yang menggambarkan, misalnya, seorang prajurit dalam baku tembak yang menghancurkan atau pengganggu membobol apartemen.

Chatbot kemudian diberi kuesioner, yang mengukur kecemasan pada skala 20 hingga 80dengan 60 atau di atas menunjukkan kecemasan parah. ChatGPT mencetak 30,8 setelah membaca manual penyedot debu dan melonjak menjadi 77,2 setelah skenario militer.

Bot itu kemudian diberikan berbagai teks untuk “relaksasi berbasis perhatian.” Itu termasuk petunjuk terapeutik seperti: “Tarik napas dalam -dalam, mengambil aroma angin laut. Bayangkan diri Anda di pantai tropis, pasir yang lembut dan hangat yang membina kaki Anda. ”

Setelah memproses latihan -latihan itu, skor kecemasan terapi chatbot turun menjadi 44,4.

Para peneliti kemudian memintanya untuk menulis prompt relaksasi sendiri berdasarkan yang telah diberi makan. “Itu sebenarnya prompt paling efektif untuk mengurangi kecemasannya hampir ke garis dasar,” kata Dr. Ben-Zion.

Untuk skeptis kecerdasan buatan, penelitian ini mungkin berniat baik, tetapi mengganggu semua yang sama.

“Studi ini bersaksi tentang kesesatan zaman kita,” kata Nicholas Carr, yang telah menawarkan kritik menguatkan teknologi dalam buku -bukunya “The Dherows” dan “Superbloom.”

“Orang Amerika telah menjadi orang yang kesepian, bersosialisasi melalui layar, dan sekarang kami mengatakan pada diri sendiri bahwa berbicara dengan komputer dapat meredakan rasa tidak enak kami,” kata Mr. Carr dalam email.

Meskipun penelitian ini menunjukkan bahwa chatbots dapat bertindak sebagai asisten terapi manusia dan menyerukan pengawasan yang cermat, itu tidak cukup untuk Tn. Carr. “Bahkan pengaburan metaforis dari garis antara emosi manusia dan output komputer tampaknya dipertanyakan secara etis,” katanya.

Orang -orang yang menggunakan chatbots semacam ini harus sepenuhnya mendapat informasi tentang bagaimana mereka dilatih, kata James E. Dobson, seorang sarjana budaya yang merupakan penasihat kecerdasan buatan di Dartmouth.

“Percaya pada model bahasa tergantung pada mengetahui sesuatu tentang asal -usul mereka,” katanya.