Algoritma 'Prediksi Pembunuhan' menggemakan beberapa kebijakan paling mengerikan di Stalin – pemerintah menginjak garis yang sangat berbahaya dalam meneliti mereka

Menggambarkan kengerian komunisme di bawah Stalin dan yang lainnya, penerima Nobel Aleksandr Solzhenitsyn menulis dalam magnum opus -nya, “The Kepulauan Gulag“Bahwa” garis yang membagi kebaikan dan jahat memotong hati setiap manusia. ” tenaga kerja Kamp tempat banyak yang tidak kembali, terjadi dengan cara yang merampas terdakwa dari proses hukum. Dalam banyak kasus, kecurigaan belaka atau bahkan mengisyaratkan bahwa tindakan terhadap rezim mungkin terjadi sudah cukup untuk mendapatkan tiket satu arah dengan sedikit atau tanpa bantuan. Premis yang mendasari di sini bahwa para pejabat tahu kapan seseorang mungkin melakukan pelanggaran. Dengan kata lain, penegakan hukum tahu Di mana garis itu terletak di hati orang -orang.

Pemerintah Inggris telah memutuskan untuk mengejar chimera ini dengan berinvestasi di a program yang berusaha untuk mengidentifikasi siapa yang mungkin melakukan pembunuhan. Secara khusus, proyek ini menggunakan data pemerintah dan polisi untuk profil orang untuk “memprediksi” yang memiliki kemungkinan tinggi untuk melakukan pembunuhan. Saat ini, program ini berada dalam tahap penelitiannya, dengan program serupa digunakan untuk konteks membuat keputusan masa percobaan.

Program seperti itu yang mengurangi poin individu ke titik data membawa risiko besar yang mungkin lebih besar daripada keuntungan. Pertama, output dari program tersebut adalah tidak bebas kesalahanartinya itu mungkin salah melibatkan orang. Kedua, kita tidak akan pernah tahu apakah prediksi tidak benar karena tidak ada cara untuk mengetahui apakah sesuatu tidak terjadi – apakah pembunuhan dicegah, atau apakah itu tidak akan pernah terjadi tetap tidak dapat dijawab? Ketiga, program ini dapat disalahgunakan oleh aktor oportunistik untuk membenarkan penargetan orang, terutama minoritas – kemampuan untuk melakukannya dipanggang menjadi birokrasi.

Pertimbangkan: dasar a keadaan birokrasi bertumpu pada kemampuannya untuk mengurangi manusia menjadi angka. Dengan melakukan itu, ia menawarkan keuntungan efisiensi dan keadilan – tidak ada yang seharusnya mendapatkan perawatan preferensial. Terlepas dari status atau pendapatan seseorang, DMV (DVLA di Inggris) akan memperlakukan aplikasi untuk SIM atau pembaruannya dengan cara yang sama. Tetapi kesalahan terjadi, dan menavigasi labirin prosedur birokrasi untuk memperbaikinya bukanlah tugas yang mudah.

Di zaman algoritma dan kecerdasan buatan (AI), masalah akuntabilitas dan bantuan ini jika terjadi kesalahan telah menjadi jauh lebih mendesak.

'Wastafel Akuntabilitas'

Ahli matematika Cathy O'Neil memiliki didokumentasikan Kasus penghentian guru sekolah yang salah karena skor yang buruk sebagaimana dihitung oleh algoritma AI. Algoritma, pada gilirannya, didorong oleh apa yang dapat dengan mudah diukur (misalnya, nilai tes) daripada efektivitas pengajaran (siswa yang berkinerja buruk meningkat secara signifikan atau seberapa banyak guru membantu siswa dengan cara yang tidak dapat diukur). Algoritma ini juga memoles apakah inflasi tingkat telah terjadi pada tahun -tahun sebelumnya. Ketika para guru menanyai pihak berwenang tentang ulasan kinerja yang menyebabkan pemecatan mereka, penjelasan yang mereka terima adalah dalam bentuk “matematika menyuruh kami melakukannya” – bahkan setelah pihak berwenang mengakui bahwa matematika yang mendasarinya tidak 100% akurat.

Jika seorang pembunuh masa depan yang potensial ditangkap sebelumnya, “Laporan Minoritas”, gaya, bagaimana kita bisa tahu jika orang itu telah memutuskan sendiri untuk tidak melakukan pembunuhan?

Akhil Bhardwaj

Dengan demikian, penggunaan algoritma menciptakan apa yang disebut jurnalis Dan Davies “Wastafel Akuntabilitas” – ini melucuti akuntabilitas dengan memastikan itu Tidak ada satu orang atau entitas yang dapat dianggap bertanggung jawabdan itu mencegah orang yang terkena dampak keputusan karena dapat memperbaiki kesalahan.

Ini menciptakan masalah dua kali lipat: estimasi algoritma dapat cacat, dan algoritma tidak memperbarui dirinya sendiri karena tidak ada yang bertanggung jawab. Tidak ada algoritma yang dapat diharapkan akurat sepanjang waktu; Ini dapat dikalibrasi dengan data baru. Tapi ini adalah pandangan idealis itu bahkan tidak benar dalam sains; Ilmuwan bisa melawan Memperbarui teori atau skema, terutama ketika mereka banyak diinvestasikan di dalamnya. Dan juga dan tidak mengejutkan, birokrasi tidak Memperbarui keyakinan mereka dengan mudah.

Untuk menggunakan algoritma dalam upaya memprediksi siapa yang berisiko melakukan pembunuhan membingungkan dan tidak etis. Tidak hanya itu bisa tidak akurat, tetapi tidak ada cara untuk mengetahui apakah sistem itu benar. Dengan kata lain, jika calon pembunuh masa depan ditangkap terlebih dahulu, “Laporan Minoritas”, bagaimana kita bisa tahu jika orang tersebut telah memutuskan sendiri untuk tidak melakukan pembunuhan? Pemerintah Inggris belum mengklarifikasi bagaimana mereka bermaksud menggunakan program ini selain menyatakan bahwa penelitian sedang dilakukan untuk keperluan “mencegah dan mendeteksi tindakan yang melanggar hukum. “

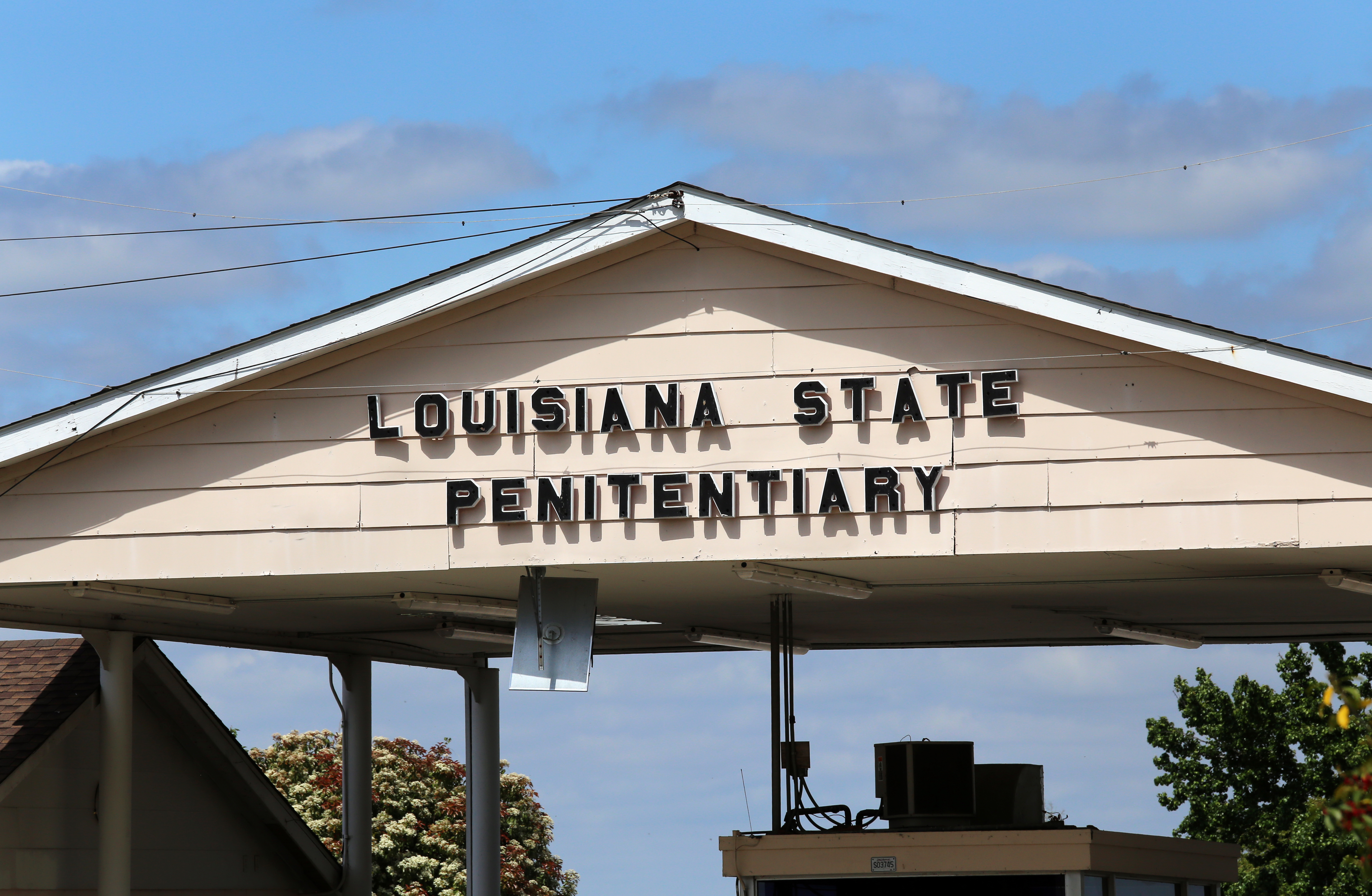

Kami sudah melihat sistem serupa digunakan di Amerika Serikat. Di Louisiana, sebuah algoritma bernama Tiger (kependekan dari “intervensi yang ditargetkan untuk meningkatkan kembali entri yang lebih besar”)-memprediksi apakah seorang narapidana dapat melakukan kejahatan jika dirilis, yang kemudian berfungsi sebagai dasar untuk membuat keputusan pembebasan bersyarat. Baru-baru ini, Seorang narapidana berusia 70 tahun yang hampir buta ditolak pembebasan bersyarat Karena Tiger memperkirakan dia memiliki risiko tinggi untuk menyinggung kembali ..

Dalam kasus lain yang akhirnya pergi ke Mahkamah Agung Wisconsin (State vs. Loomis), sebuah algoritma digunakan untuk memandu hukuman. Tantangan untuk kalimat – termasuk permintaan untuk akses ke algoritma untuk menentukan bagaimana mencapai rekomendasinya – ditolak dengan alasan bahwa teknologi tersebut adalah hak milik. Intinya, ketidaksopanan teknologi sistem tersebut diperparah dengan cara yang berpotensi dirusak proses hukum.

Sama, jika tidak lebih meresahkan, dataset yang mendasari program di Inggris – awalnya dijuluki Proyek Prediksi Pembunuhan – Terdiri dari ratusan ribu orang yang tidak pernah memberikan izin untuk data mereka untuk digunakan untuk melatih sistem. Lebih buruk lagi, dataset – disusun Menggunakan data dari Kementerian, Polisi Kehakiman Manchester yang lebih besar, dan Komputer Nasional Polisi-berisi data pribadi, termasuk, tetapi tidak terbatas pada, informasi tentang kecanduan, kesehatan mental, disabilitas, contoh sebelumnya melukai diri sendiri, dan apakah mereka telah menjadi korban kejahatan. Indikator seperti jenis kelamin dan ras juga disertakan.

Variabel -variabel ini secara alami meningkatkan kemungkinan bias terhadap etnis minoritas dan kelompok yang terpinggirkan lainnya. Jadi prediksi algoritma mungkin hanya mencerminkan pilihan kepolisian di masa lalu – algoritma prediktif AI induksi statistikjadi mereka memproyeksikan pola (meresahkan) dalam data ke masa depan.

Selain itu, data yang terlalu tinggi melanggar pelanggar kulit hitam dari daerah yang makmur serta semua etnis dari lingkungan yang dirampas. Studi sebelumnya menunjukkan bahwa algoritma AI yang membuat prediksi tentang perilaku bekerja lebih baik untuk Pelanggar hitam dari yang mereka lakukan untuk yang lain kelompok. Temuan seperti itu tidak banyak untuk menghilangkan asli Ketakutan bahwa kelompok minoritas rasial dan kelompok -kelompok rentan lainnya akan ditargetkan secara tidak adil.

Dalam bukunya, Solzhenitsyn memberi tahu dunia barat tentang kengerian negara birokrasi yang menggulung warganya dalam melayani cita -cita, dengan sedikit memperhatikan pengalaman hidup manusia. Negara bagian itu hampir selalu salah (terutama dengan alasan moral), tetapi, tentu saja, tidak ada culpa. Mereka yang dianiaya hanyalah kerusakan jaminan yang harus dilupakan.

Sekarang, setengah abad kemudian, agak aneh bahwa demokrasi seperti Inggris meninjau kembali proyek yang mengerikan dan gagal dari negara komunis otoriter sebagai cara “melindungi publik“Publik memang perlu dilindungi – tidak hanya dari penjahat tetapi juga dari A”Technopoly“Itu sangat melebih -lebihkan peran teknologi dalam membangun dan memelihara masyarakat yang sehat.