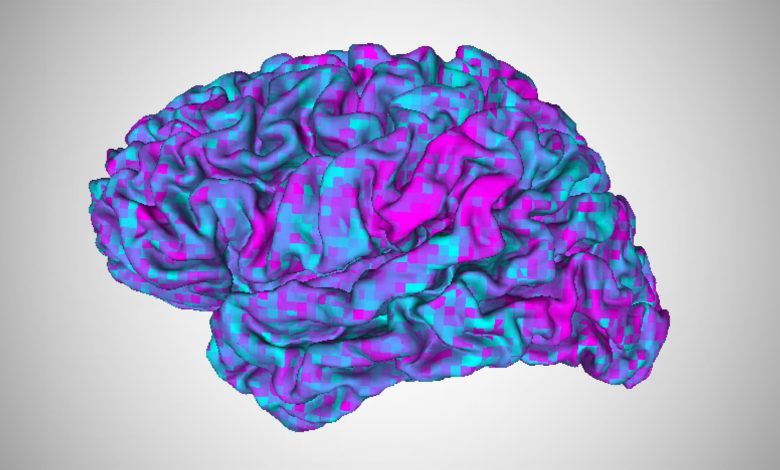

AI 'Decoder Otak' dapat membaca pikiran seseorang hanya dengan pemindaian otak yang cepat dan hampir tidak ada pelatihan

Para ilmuwan telah membuat perbaikan baru pada “decoder otak” yang menggunakan kecerdasan buatan (Ai) untuk mengubah pikiran menjadi teks.

Algoritma konverter baru mereka dapat dengan cepat melatih decoder yang ada di otak orang lain, tim melaporkan dalam sebuah studi baru. Temuan suatu hari nanti dapat mendukung orang dengan afasia, gangguan otak yang memengaruhi kemampuan seseorang untuk berkomunikasi, kata para ilmuwan.

Dekoder otak menggunakan pembelajaran mesin untuk menerjemahkan pikiran seseorang ke dalam teks, berdasarkan tanggapan otak mereka terhadap cerita yang telah mereka dengarkan. Namun, Iterasi masa lalu dari decoder Mewajibkan peserta untuk mendengarkan cerita di dalam mesin MRI selama berjam -jam, dan decoder ini hanya bekerja untuk orang -orang yang dilatih.

“Orang dengan afasia seringkali mengalami kesulitan memahami bahasa serta menghasilkan bahasa,” kata rekan penulis studi Alexander Huthseorang ahli saraf komputasi di University of Texas di Austin (UT Austin). “Jadi jika itu masalahnya, maka kita mungkin tidak dapat membangun model untuk otak mereka sama sekali dengan menonton bagaimana otak mereka merespons cerita yang mereka dengarkan.”

Dalam penelitian baru, diterbitkan 6 Februari di jurnal Biologi Saat IniHuth dan rekan penulis Jerry Tangseorang mahasiswa pascasarjana di UT Austin menyelidiki bagaimana mereka dapat mengatasi keterbatasan ini. “Dalam penelitian ini, kami bertanya, dapatkah kami melakukan sesuatu secara berbeda?” katanya. “Bisakah kita mentransfer dekoder yang kita bangun untuk otak satu orang ke otak orang lain?”

Para peneliti pertama -tama melatih dekoder otak pada beberapa peserta referensi jauh – dengan mengumpulkan data MRI fungsional sementara para peserta mendengarkan 10 jam cerita radio.

Kemudian, mereka melatih dua algoritma konverter pada peserta referensi dan pada serangkaian peserta “tujuan” yang berbeda: satu menggunakan data yang dikumpulkan sementara para peserta menghabiskan 70 menit mendengarkan cerita radio, dan yang lainnya sementara mereka menghabiskan 70 menit menonton film pendek Silent Pixar Short Tidak terkait dengan cerita radio.

Menggunakan teknik yang disebut penyelarasan fungsional, tim memetakan bagaimana referensi dan otak peserta menanggapi cerita audio atau film yang sama. Mereka menggunakan informasi itu untuk melatih decoder agar bekerja dengan otak peserta tujuan, tanpa perlu mengumpulkan beberapa jam data pelatihan.

Selanjutnya, tim menguji decoder menggunakan cerita pendek yang tidak pernah didengar oleh para peserta sebelumnya. Meskipun prediksi decoder sedikit lebih akurat untuk peserta referensi asli daripada untuk orang -orang yang menggunakan konverter, kata -kata yang diprediksi dari pemindaian otak masing -masing peserta masih secara semantik terkait dengan yang digunakan dalam cerita uji.

Misalnya, bagian dari kisah uji termasuk seseorang yang membahas pekerjaan yang tidak mereka nikmati, dengan mengatakan, “Saya seorang pelayan di ruang es krim. Jadi, um, itu bukan … saya tidak tahu di mana saya ingin tetapi saya tahu bukan itu. ” Dekoder menggunakan algoritma konverter yang dilatih pada data film yang diprediksi: “Saya berada di pekerjaan yang saya pikir membosankan. Saya harus menerima pesanan dan saya tidak menyukai mereka, jadi saya mengerjakannya setiap hari. ” Bukan pertandingan yang tepat – decoder tidak membacakan suara yang tepat yang didengar orang, kata Huth – tetapi idenya terkait.

“Hal yang sangat mengejutkan dan keren adalah kami dapat melakukan ini bahkan tidak menggunakan data bahasa,” kata Huth kepada Live Science. “Jadi kita dapat memiliki data yang kita kumpulkan hanya saat seseorang menonton video bisu, dan kemudian kita dapat menggunakannya untuk membangun decoder bahasa ini untuk otak mereka.”

Menggunakan konverter berbasis video untuk mentransfer decoder yang ada ke orang-orang dengan afasia dapat membantu mereka mengekspresikan pemikiran mereka, kata para peneliti. Ini juga mengungkapkan beberapa tumpang tindih antara cara manusia mewakili ide -ide dari bahasa dan dari narasi visual di otak.

“Studi ini menunjukkan bahwa ada beberapa representasi semantik yang tidak peduli dari modalitas mana itu datang,” Yukiyasu kamitaniseorang ahli saraf komputasi di Universitas Kyoto yang tidak terlibat dalam penelitian ini, mengatakan kepada Live Science. Dengan kata lain, ini membantu mengungkapkan bagaimana otak mewakili konsep -konsep tertentu dengan cara yang sama, bahkan ketika mereka disajikan dalam format yang berbeda.,

Langkah -langkah berikutnya adalah untuk menguji konverter pada peserta dengan afasia dan “membangun antarmuka yang akan membantu mereka menghasilkan bahasa yang ingin mereka hasilkan,” kata Huth.