Model AI lanjutan menghasilkan emisi CO₂ hingga 50 kali lebih banyak daripada LLM yang lebih umum saat menjawab pertanyaan yang sama

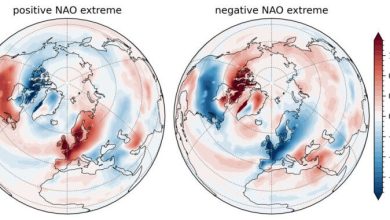

Semakin akurat kami mencoba membuat model AI, semakin besar jejak karbon mereka – dengan beberapa petunjuk menghasilkan emisi karbon dioksida hingga 50 kali lebih banyak daripada yang lain, sebuah studi baru terungkap.

Model penalaran, seperti Claude Antropik, O3 Openai dan Deepseek's R1, adalah model bahasa besar khusus (LLM) yang mendedikasikan lebih banyak waktu dan daya komputasi untuk menghasilkan tanggapan yang lebih akurat dari pendahulunya.

Namun, selain dari beberapa hasil yang mengesankan, model -model ini telah terbukti menghadapi berat batasan dalam kemampuan mereka untuk memecahkan masalah yang kompleks. Sekarang, tim peneliti telah menyoroti kendala lain pada kinerja model – jejak karbon selangit mereka. Mereka menerbitkan temuan mereka 19 Juni di jurnal Perbatasan dalam Komunikasi.

“Dampak lingkungan dari mempertanyakan LLMS terlatih sangat ditentukan oleh pendekatan penalaran mereka, dengan proses penalaran eksplisit secara signifikan menaikkan konsumsi energi dan emisi karbon,” Studi First Author Maximilian DaunerSeorang peneliti di Universitas Munich University of Applied Sciences di Jerman, kata dalam sebuah pernyataan. “Kami menemukan bahwa model yang diaktifkan oleh penalaran menghasilkan emisi CO₂ hingga 50 kali lebih banyak daripada model respons yang ringkas.”

Untuk menjawab petunjuk yang diberikan kepada mereka, LLM memecah bahasa menjadi token – potongan kata yang dikonversi menjadi serangkaian angka sebelum dimasukkan ke dalam jaringan saraf. Jaringan saraf ini disetel menggunakan data pelatihan yang menghitung probabilitas pola tertentu yang muncul. Mereka kemudian menggunakan probabilitas ini untuk menghasilkan tanggapan.

Model penalaran lebih lanjut upaya untuk meningkatkan akurasi menggunakan proses yang dikenal sebagai “rantai-pemikiran.” Ini adalah teknik yang bekerja dengan memecah satu masalah kompleks menjadi langkah perantara yang lebih kecil dan lebih mudah dicerna yang mengikuti aliran logis, meniru bagaimana manusia mungkin sampai pada kesimpulan untuk masalah yang sama.

Terkait: Ai 'berhalusinat' terus -menerus, tetapi ada solusi

Namun, model ini memiliki tuntutan energi yang jauh lebih tinggi dari LLM konvensional, menimbulkan hambatan ekonomi potensial untuk perusahaan dan pengguna yang ingin menggunakannya. Namun, terlepas dari beberapa Penelitian tentang Dampak Lingkungan Adopsi AI yang tumbuh secara lebih umum, perbandingan antara jejak karbon dari model yang berbeda tetap relatif jarang.

Biaya penalaran

Untuk memeriksa emisi CO₂ yang dihasilkan oleh model yang berbeda, para ilmuwan di balik penelitian baru ini mengajukan 14 LLMS 1.000 pertanyaan di berbagai topik. Model yang berbeda memiliki antara 7 dan 72 miliar parameter.

Perhitungan dilakukan dengan menggunakan kerangka kerja Perun (yang menganalisis kinerja LLM dan energi yang dibutuhkannya) pada GPU NVIDIA A100. Tim kemudian mengubah penggunaan energi menjadi CO₂ dengan mengasumsikan setiap kilowatt-jam energi menghasilkan 480 gram CO₂.

Hasil mereka menunjukkan bahwa, rata -rata, model penalaran menghasilkan 543,5 token per pertanyaan dibandingkan dengan hanya 37,7 token untuk model yang lebih ringkas. Token ekstra ini – sebesar lebih banyak perhitungan – berarti bahwa model penalaran yang lebih akurat menghasilkan lebih banyak CO₂.

Model yang paling akurat adalah model Cogito parameter 72 miliar, yang menjawab 84,9% dari pertanyaan benchmark dengan benar. Cogito dirilis tiga kali emisi CO₂ dari model berukuran sama yang dibuat untuk menghasilkan jawaban lebih ringkas.

“Saat ini, kami melihat trade-off akurasi yang jelas yang melekat dalam teknologi LLM,” kata Dauner. “Tidak ada model yang menyimpan emisi di bawah 500 gram setara CO₂ [total greenhouse gases released] mencapai akurasi yang lebih tinggi dari 80% untuk menjawab 1.000 pertanyaan dengan benar. “

Tetapi masalah melampaui akurasi. Pertanyaan yang membutuhkan waktu penalaran yang lebih lama, seperti dalam aljabar atau filsafat, menyebabkan emisi melonjak enam kali lebih tinggi daripada pertanyaan pencarian langsung.

Perhitungan para peneliti juga menunjukkan bahwa emisi bergantung pada model yang dipilih. Untuk menjawab 60.000 pertanyaan, model R1 Parameter Deepseek 70 miliar akan menghasilkan CO₂ yang dipancarkan dengan penerbangan pulang pergi antara New York dan London. Namun, model Parameter Qwen 2.5 Alibaba Cloud, akan dapat menjawabnya dengan tingkat akurasi yang sama untuk sepertiga dari emisi.

Temuan penelitian ini tidak pasti; Emisi dapat bervariasi tergantung pada perangkat keras yang digunakan dan grid energi yang digunakan untuk memasok daya mereka, para peneliti menekankan. Tetapi mereka harus meminta pengguna AI untuk berpikir sebelum mereka menggunakan teknologi, para peneliti mencatat ..

“Jika pengguna mengetahui biaya CO₂ yang tepat dari output yang dihasilkan AI, seperti dengan santai mengubah diri mereka menjadi figur aksi, mereka mungkin lebih selektif dan bijaksana tentang kapan dan bagaimana mereka menggunakan teknologi ini,” kata Dauner.