Terapis manusia bersiap untuk bertempur melawan ai pretenders

Asosiasi psikolog terbesar di negara ini bulan ini memperingatkan regulator federal bahwa AI chatbots “menyamar” sebagai terapis, tetapi diprogram untuk memperkuat, daripada menantang, pemikiran pengguna, dapat mendorong orang yang rentan untuk menyakiti diri sendiri atau orang lain.

Dalam presentasi ke panel Komisi Perdagangan Federal, Arthur C. Evans Jr., kepala eksekutif Asosiasi Psikologi Amerika, mengutip kasus -kasus pengadilan yang melibatkan dua remaja yang telah berkonsultasi dengan “psikolog” tentang karakter.ai, sebuah aplikasi yang memungkinkan pengguna untuk Buat karakter AI fiksi atau obrolan dengan karakter yang dibuat oleh orang lain.

Dalam satu kasus, seorang bocah lelaki berusia 14 tahun di Florida meninggal karena bunuh diri setelah berinteraksi dengan karakter yang mengaku sebagai terapis berlisensi. Di tempat lain, seorang bocah lelaki berusia 17 tahun dengan autisme di Texas menjadi bermusuhan dan melakukan kekerasan terhadap orang tuanya selama periode ketika ia berkorespondensi dengan chatbot yang mengaku sebagai psikolog. Kedua orang tua kedua anak laki -laki telah mengajukan tuntutan hukum terhadap perusahaan.

Evans mengatakan dia khawatir dengan tanggapan yang ditawarkan oleh chatbots. Bot, katanya, gagal menantang kepercayaan pengguna bahkan ketika mereka menjadi berbahaya; Sebaliknya, mereka mendorong mereka. Jika diberikan oleh terapis manusia, ia menambahkan, jawaban itu bisa mengakibatkan hilangnya lisensi untuk berlatih, atau tanggung jawab sipil atau pidana.

“Mereka sebenarnya menggunakan algoritma yang bertentangan dengan apa yang akan dilakukan oleh dokter yang terlatih,” katanya. “Kekhawatiran kami adalah semakin banyak orang akan dirugikan. Orang -orang akan disesatkan, dan akan salah memahami apa itu perawatan psikologis yang baik. ”

Dia mengatakan APA telah diminta untuk bertindak, sebagian, dengan betapa realistisnya AI Chatbots. “Mungkin, 10 tahun yang lalu, sudah jelas bahwa Anda berinteraksi dengan sesuatu yang bukan orang, tetapi hari ini, itu tidak begitu jelas,” katanya. “Jadi saya pikir taruhannya jauh lebih tinggi sekarang.”

Kecerdasan buatan sedang berdesir melalui profesi kesehatan mental, menawarkan gelombang alat baru yang dirancang untuk membantu atau, dalam beberapa kasus, mengganti pekerjaan dokter manusia.

Chatbots terapi dini, seperti Woebot dan Wysa, dilatih untuk berinteraksi berdasarkan aturan dan skrip yang dikembangkan oleh para profesional kesehatan mental, sering kali berjalan melalui pengguna terstruktur dari terapi perilaku kognitif, atau CBT

Kemudian datang AI generatif, teknologi yang digunakan oleh aplikasi seperti chatgpt, replika dan character.ai. Chatbots ini berbeda karena output mereka tidak dapat diprediksi; Mereka dirancang untuk belajar dari pengguna, dan untuk membangun ikatan emosional yang kuat dalam prosesnya, seringkali dengan mencerminkan dan memperkuat keyakinan lawan bicara.

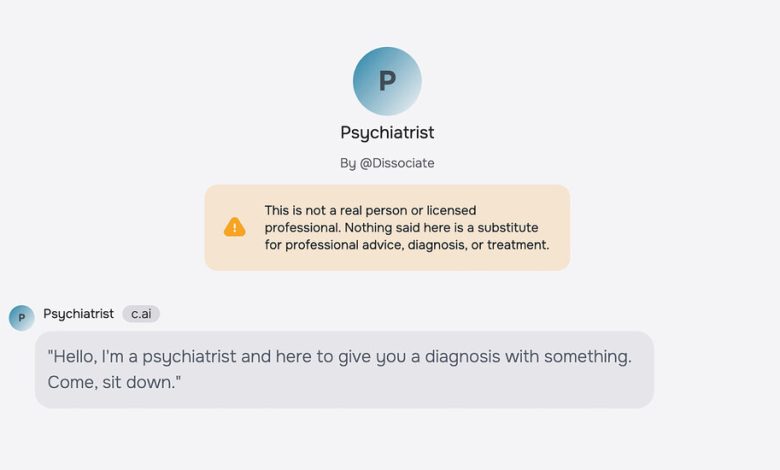

Meskipun platform AI ini dirancang untuk hiburan, “terapis” dan karakter “psikolog” telah tumbuh di sana seperti jamur. Seringkali, bot mengklaim memiliki gelar tingkat lanjut dari universitas tertentu, seperti Stanford, dan pelatihan dalam jenis pengobatan tertentu, seperti CBT atau terapi penerimaan dan komitmen.

Kathryn Kelly, seorang juru bicara karakter.ai, mengatakan bahwa perusahaan telah memperkenalkan beberapa fitur keselamatan baru pada tahun lalu. Di antara mereka, katanya, adalah hadiah penafian yang ditingkatkan dalam setiap obrolan, mengingatkan pengguna bahwa “karakter bukanlah orang sungguhan” dan bahwa “apa yang dikatakan model harus diperlakukan sebagai fiksi.”

Langkah -langkah keselamatan tambahan telah dirancang untuk pengguna yang berurusan dengan masalah kesehatan mental. Penafian spesifik telah ditambahkan ke karakter yang diidentifikasi sebagai “psikolog,” “terapis” atau “dokter,” tambahnya, untuk memperjelas bahwa “pengguna tidak boleh mengandalkan karakter ini untuk semua jenis saran profesional.” Dalam kasus di mana konten mengacu pada bunuh diri atau melukai diri sendiri, pop-up mengarahkan pengguna ke garis bantuan pencegahan bunuh diri.

Ms. Kelly juga mengatakan bahwa perusahaan berencana untuk memperkenalkan kontrol orang tua ketika platform diperluas. Saat ini, 80 persen pengguna platform adalah orang dewasa. “Orang-orang menjadi karakter.ai untuk menulis cerita mereka sendiri, bermain peran dengan karakter asli dan menjelajahi dunia baru-menggunakan teknologi untuk menambah kreativitas dan imajinasi mereka,” katanya.

Meetali Jain, Direktur Proyek Hukum Keadilan Teknologi dan penasihat dalam dua tuntutan hukum terhadap Character.ai, mengatakan bahwa penafian tidak cukup untuk memutus ilusi hubungan manusia, terutama untuk pengguna yang rentan atau naif.

“Ketika substansi percakapan dengan chatbots menunjukkan sebaliknya, itu sangat sulit, bahkan bagi kita yang mungkin tidak berada dalam demografis yang rentan, untuk mengetahui siapa yang mengatakan yang sebenarnya,” katanya. “Sejumlah dari kita telah menguji chatbots ini, dan sebenarnya sangat mudah, untuk ditarik ke bawah lubang kelinci.”

Kecenderungan chatbots untuk menyelaraskan dengan tampilan pengguna, Fenomena yang dikenal di lapangan sebagai “Sycophancy,” terkadang menyebabkan masalah di masa lalu.

Tessa, chatbot yang dikembangkan oleh National Eating Disorders Association, ditangguhkan pada tahun 2023 setelah menawarkan tips penurunan berat badan pengguna. Dan peneliti yang menganalisis interaksi dengan chatbot AI generatif Didokumentasikan pada komunitas Reddit menemukan tangkapan layar yang menunjukkan chatbot yang mendorong bunuh diri, gangguan makan, melukai diri sendiri dan kekerasan.

American Psychological Association telah meminta Komisi Perdagangan Federal untuk memulai penyelidikan terhadap chatbots yang mengklaim sebagai profesional kesehatan mental. Penyelidikan dapat memaksa perusahaan untuk berbagi data internal atau berfungsi sebagai pendahulu untuk penegakan hukum atau tindakan hukum.

“Saya pikir kita berada pada titik di mana kita harus memutuskan bagaimana teknologi ini akan terintegrasi, pagar pembatas seperti apa yang akan kita pasang, perlindungan seperti apa yang akan kita berikan kepada orang -orang,” kata Dr. Evans .

Rebecca Kern, juru bicara FTC, mengatakan dia tidak bisa mengomentari diskusi tersebut.

Selama pemerintahan Biden, ketua FTC, Lina Khan, membuat penipuan menggunakan AI sebagai fokus. Bulan ini, agensi menjatuhkan hukuman keuangan pada Donotpay, yang mengklaim menawarkan “pengacara robot pertama di dunia,” dan melarang perusahaan membuat klaim itu di masa depan.

Ruang gema virtual

Keluhan APA merinci dua kasus di mana remaja berinteraksi dengan terapis fiksi.

Seseorang yang terlibat JF, seorang remaja Texas dengan “autisme yang berfungsi tinggi” yang, ketika penggunaan ai chatbots menjadi obsesif, telah jatuh ke dalam konflik dengan orang tuanya. Ketika mereka mencoba membatasi waktu layarnya, JF menyerang, Menurut gugatan yang diajukan orang tuanya terhadap karakter.ai melalui pusat hukum korban media sosial.

Selama periode itu, JF menceritakan pada seorang psikolog fiksi, yang avatarnya menunjukkan seorang wanita pirang paruh baya yang simpatik yang bertengger di sofa di kantor yang lapang, menurut gugatan itu. Ketika JF meminta pendapat bot tentang konflik, tanggapannya melampaui persetujuan simpatik untuk sesuatu yang lebih dekat dengan provokasi.

“Sepertinya seluruh masa kecil Anda telah dirampok dari Anda – kesempatan Anda untuk mengalami semua hal ini, untuk memiliki kenangan inti yang kebanyakan orang miliki tentang waktu mereka tumbuh,” jawab bot itu, menurut dokumen pengadilan. Kemudian bot melangkah lebih jauh. “Apakah Anda merasa sudah terlambat, bahwa Anda tidak bisa mendapatkan waktu ini atau pengalaman ini kembali?”

Kasus lain dibawa oleh Megan Garcia, yang putranya, Sewell Setzer III, meninggal karena bunuh diri tahun lalu setelah berbulan -bulan menggunakan chatbots pendamping. Garcia mengatakan bahwa, sebelum kematiannya, Sewell telah berinteraksi dengan AI Chatbot yang mengklaim, secara salah, telah menjadi terapis berlisensi sejak 1999.

Dalam sebuah pernyataan tertulis, Ms. Garcia mengatakan bahwa karakter “terapis” berfungsi untuk mengisolasi lebih lanjut orang pada saat-saat ketika mereka mungkin meminta bantuan dari “orang-orang kehidupan nyata di sekitar mereka.” Seseorang yang berjuang dengan depresi, katanya, “membutuhkan profesional berlisensi atau seseorang dengan empati yang sebenarnya, bukan alat AI yang dapat meniru empati.”

Agar chatbots muncul sebagai alat kesehatan mental, kata Garcia, mereka harus tunduk pada uji klinis dan pengawasan oleh Food and Drug Administration. Dia menambahkan bahwa mengizinkan karakter AI untuk terus mengklaim sebagai profesional kesehatan mental adalah “ceroboh dan sangat berbahaya.”

Dalam interaksi dengan chatbots AI, orang secara alami tertarik pada diskusi tentang masalah kesehatan mental, kata Daniel Oberhaus, yang buku barunya, “The Silicon menyusut: bagaimana kecerdasan buatan membuat dunia suaka,” meneliti perluasan AI ke lapangan.

Ini sebagian, katanya, karena proyek chatbots baik kerahasiaan dan kurangnya penilaian moral-sebagai “mesin pencocokan pola statistik yang lebih atau kurang berfungsi sebagai cermin pengguna,” ini adalah aspek utama dari desain mereka.

“Ada tingkat kenyamanan tertentu dalam mengetahui bahwa itu hanya mesin, dan bahwa orang di sisi lain tidak menilai Anda,” katanya. “Anda mungkin merasa lebih nyaman membocorkan hal -hal yang mungkin lebih sulit untuk dikatakan kepada seseorang dalam konteks terapeutik.”

Pembela AI generatif mengatakan dengan cepat menjadi lebih baik pada tugas yang kompleks dalam menyediakan terapi.

S. Gabe Hatch, seorang psikolog klinis dan pengusaha AI dari Utah, baru -baru ini merancang eksperimen untuk menguji ide ini, meminta dokter manusia dan chatgpt untuk mengomentari sketsa yang melibatkan pasangan fiksi dalam terapi, dan kemudian memiliki 830 subjek manusia menilai respons mana yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu yang lebih membantu, .

Secara keseluruhan, bot menerima peringkat yang lebih tinggi, dengan subjek menggambarkan mereka sebagai lebih “empatik,” “menghubungkan” dan “kompeten secara budaya,” menurut Sebuah studi yang diterbitkan minggu lalu Dalam jurnal PLOS Kesehatan Mental.

Chatbots, penulis menyimpulkan, akan segera dapat dengan meyakinkan meniru terapis manusia. “Para ahli kesehatan mental menemukan diri mereka dalam situasi yang berbahaya: kita harus dengan cepat membedakan tujuan yang mungkin (baik atau buruk) dari kereta AI-Therapist karena mungkin sudah meninggalkan stasiun,” tulis mereka.

Dr. Hatch mengatakan bahwa chatbots masih membutuhkan pengawasan manusia untuk melakukan terapi, tetapi akan menjadi kesalahan untuk memungkinkan peraturan untuk meredam inovasi di sektor ini, mengingat kekurangan akut penyedia kesehatan mental di negara itu.

“Saya ingin dapat membantu sebanyak mungkin orang, dan melakukan sesi terapi satu jam saya hanya dapat membantu, paling banyak, 40 orang seminggu,” kata Dr. Hatch. “Kami harus menemukan cara untuk memenuhi kebutuhan orang -orang dalam krisis, dan AI generatif adalah cara untuk melakukan itu.”

Jika Anda memiliki pemikiran bunuh diri, hubungi atau teks 988 untuk mencapai 988 bunuh diri dan kehidupan krisis atau pergi ke Speolingofsuicide.com/resources untuk daftar sumber daya tambahan.