Model AI terbaru Openai memiliki perlindungan baru untuk mencegah biorisk

Openai mengatakan bahwa mereka menggunakan sistem baru untuk memantau model penalaran AI terbarunya, O3 dan O4-Miniuntuk petunjuk yang terkait dengan ancaman biologis dan kimia. Sistem ini bertujuan untuk mencegah model menawarkan saran yang dapat menginstruksikan seseorang untuk melakukan serangan yang berpotensi berbahaya, Menurut Laporan Keselamatan Openai.

O3 dan O4-Mini mewakili peningkatan kemampuan yang berarti pada model Openai sebelumnya, kata perusahaan itu, dan dengan demikian menimbulkan risiko baru di tangan aktor jahat. Menurut tolok ukur internal Openai, O3 lebih terampil dalam menjawab pertanyaan tentang menciptakan jenis ancaman biologis tertentu pada khususnya. Untuk alasan ini-dan untuk mengurangi risiko lain-Openai menciptakan sistem pemantauan baru, yang digambarkan perusahaan sebagai “monitor penalaran yang berfokus pada keselamatan.”

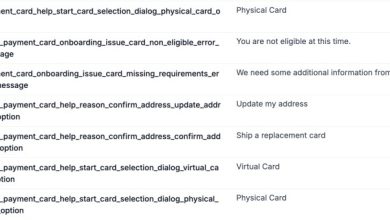

Monitor, terlatih khusus untuk alasan tentang kebijakan konten Openai, berjalan di atas O3 dan O4-Mini. Ini dirancang untuk mengidentifikasi petunjuk yang terkait dengan risiko biologis dan kimia dan menginstruksikan model untuk menolak memberikan saran tentang topik -topik tersebut.

Untuk menetapkan garis dasar, Openai meminta tim merah menghabiskan sekitar 1.000 jam menandai percakapan terkait biorisk “tidak aman” dari O3 dan O4-Mini. Selama pengujian di mana Openai mensimulasikan “logika pemblokiran” dari monitor keselamatannya, model menolak untuk menanggapi permintaan berisiko 98,7% dari waktu, menurut OpenAI.

Openai mengakui bahwa tesnya tidak memperhitungkan orang -orang yang mungkin mencoba petunjuk baru setelah diblokir oleh monitor, itulah sebabnya perusahaan mengatakan akan terus bergantung sebagian pada pemantauan manusia.

O3 dan O4-Mini tidak melintasi ambang batas “berisiko tinggi” Openai untuk biorisk, menurut perusahaan. Namun, dibandingkan dengan O1 dan GPT-4, Openai mengatakan bahwa versi awal O3 dan O4-Mini terbukti lebih membantu dalam menjawab pertanyaan seputar pengembangan senjata biologis.

Perusahaan ini secara aktif melacak bagaimana modelnya dapat memudahkan pengguna jahat untuk mengembangkan ancaman kimia dan biologis, menurut Openai yang baru -baru ini diperbarui Kerangka Kesiapan.

Openai semakin mengandalkan sistem otomatis untuk mengurangi risiko dari modelnya. Misalnya, untuk mencegah Generator gambar asli GPT-4O dari menciptakan materi pelecehan seksual anak (CSAM)Openai mengatakan menggunakan monitor penalaran yang mirip dengan perusahaan yang digunakan perusahaan untuk O3 dan O4-Mini.

Namun beberapa peneliti telah menimbulkan kekhawatiran Openai tidak memprioritaskan keselamatan sebanyak yang seharusnya. Salah satu mitra tim merah perusahaan, Metr, mengatakan bahwa mereka relatif sedikit waktu untuk menguji O3 pada tolok ukur untuk perilaku menipu. Sementara itu, Openai memutuskan untuk tidak melepaskan a Laporan Keselamatan untuk model GPT-4.1-nyayang diluncurkan awal minggu ini.